在当今数据驱动的时代,大数据技术已成为众多行业转型升级的关键引擎。学习大数据技术,远不止于理解其概念与架构,更重要的是熟练掌握一系列核心工具,以实现高效、可靠的数据处理。这不仅是技术能力的体现,更是将数据价值转化为业务洞察力的实践基础。

一、 理解大数据技术的基石:从概念到生态

学习大数据技术,首先需明晰其核心特征——通常以“4V”(Volume体量、Velocity速度、Variety多样、Value价值)概括。这决定了传统数据处理方式难以为继,催生了以Hadoop、Spark等为代表的分布式计算框架。这些框架构成了大数据处理的底层基础设施,其设计哲学(如分而治之、移动计算而非移动数据)是理解所有上层工具的逻辑起点。

二、 掌握数据处理的核心工具链

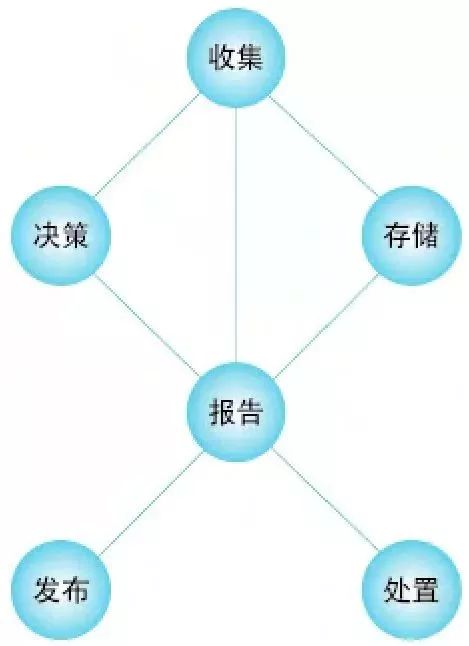

数据处理是大数据技术栈中承上启下的核心环节,涉及采集、存储、计算、分析等多个阶段,每个阶段都依赖特定的工具集。

- 数据采集与传输工具:数据处理的源头。需要掌握如Apache Kafka(高吞吐量分布式消息队列)、Flume(日志收集)、Sqoop(关系数据库与Hadoop间数据传输)等,它们负责从各类源头实时或批量地将数据汇聚到数据湖或数据仓库中。

- 数据存储与管理工具:数据的安居之所。HDFS(Hadoop分布式文件系统)是经典的批量数据存储基石;而面对实时查询,则需要掌握HBase(列式数据库)、Cassandra等NoSQL数据库。数据仓库工具如Hive(提供SQL接口查询HDFS数据)和云原生数据湖仓一体方案(如Delta Lake、Iceberg)也日益重要。

- 数据计算与处理引擎:这是发挥数据价值的核心“发动机”。

- 批处理:Apache Spark凭借其内存计算和丰富的API(Scala、Java、Python、R),已成为批处理的首选,其性能远超经典的MapReduce。

- 流处理:对于实时数据流,需掌握Apache Flink(低延迟、高吞吐、状态精确一次处理)或Spark Streaming(微批处理模型)。

- 交互式查询:工具如Presto、Impala,能够对海量数据进行亚秒级交互式SQL查询。

- 数据调度与协调工具:确保复杂的数据处理流程有序、自动化运行。Apache Airflow(以代码定义工作流)和DolphinScheduler是任务调度的主流选择;而ZooKeeper则提供分布式协调服务,保障集群的可靠运行。

三、 构建高效数据处理能力的关键实践

仅仅知道工具名称远远不够,真正的掌握体现在:

- 环境搭建与集群管理:能够在本地或云上(如AWS EMR、阿里云EMR)熟练部署、配置和维护一个大数据集群,理解各组件间的协作关系。

- 编程与开发:深入使用至少一种主流语言(推荐Scala或Python)进行Spark/Flink应用开发,编写高效、健壮的数据处理作业。

- 性能调优:能够根据数据特性和业务需求,对作业进行性能调优,例如调整Spark的并行度、内存分配、选择合理的存储格式(如Parquet、ORC)与压缩算法。

- 问题排查与调试:熟练查看各类工具的运行日志(如YARN日志、Spark UI),快速定位并解决数据处理过程中的故障与瓶颈。

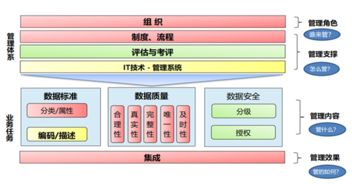

- 融入数据治理与质量:在数据处理流程中融入数据质量检查、元数据管理(如Apache Atlas)和数据血缘追踪的意识,确保产出数据的可信度。

四、 学习建议与路径规划

建议采取“理论->核心工具->系统实践”的路径:

- 夯实理论基础:理解分布式系统原理、CAP定理、数据模型等。

- 聚焦核心工具:优先深度掌握Hadoop(HDFS, YARN)、Spark(Core, SQL, Streaming)和一门数据库(如Hive或HBase)。

- 动手实践项目:从搭建环境开始,完成一个端到端的数据处理项目,例如“网站日志分析系统”,涵盖数据采集(Kafka)、存储(HDFS/Hive)、处理(Spark)、可视化等全流程。

- 拓展与深化:根据兴趣方向,深入流处理(Flink)、云原生大数据架构或特定领域(如机器学习库MLlib)。

学习大数据技术是一场结合深度与广度的旅程。对数据处理工具的熟练掌握,是将大数据宏伟蓝图变为现实生产力的关键阶梯。唯有通过持续的理论学习、工具实践和项目锤炼,才能在大数据的浪潮中游刃有余,真正驾驭数据,赋能决策与创新。