在当今人工智能的浪潮中,大型语言模型(如GPT、BERT等)的崛起标志着自然语言处理领域的重大突破。这些模型卓越性能的背后,往往离不开一个关键但常被忽视的环节——数据处理。数据处理不仅是模型训练的起点,更是决定模型质量、性能及伦理安全的核心因素。本文旨在探讨大模型预训练中数据处理的各个环节及其背后的深层思考。

一、数据采集:广度与质量的平衡

数据采集是构建预训练数据集的第一步,其核心挑战在于如何在数据的广度(数量与多样性)与质量(准确性、代表性)之间找到平衡。

- 广度追求:大模型需要海量数据以学习语言中的复杂模式和世界知识。数据来源通常包括互联网公开文本(如网页、书籍、学术论文)、专业领域语料以及多语言资料。广泛的数据覆盖有助于模型获得通用知识,减少偏见,并提升其泛化能力。

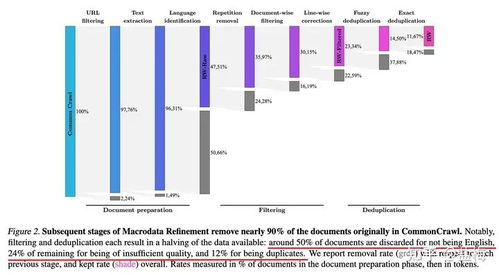

- 质量把控:并非所有数据都适宜训练。低质量数据(如垃圾信息、错误内容、重复文本)可能引入噪声,影响模型性能。因此,数据清洗成为必要步骤,包括去重、过滤不当内容、修正格式错误等。数据的时效性也需考虑,特别是在快速变化的领域(如科技、新闻)。

二、数据预处理:标准化与增强的策略

预处理是将原始数据转化为模型可读格式的关键环节,其目标在于提升数据的一致性和学习效率。

- 文本标准化:包括分词(将文本拆分为词或子词单元)、大小写统一、特殊字符处理等。例如,BERT使用的WordPiece分词法能有效处理未登录词,而GPT系列采用的字节对编码(BPE)则平衡了词汇表大小与表示能力。

- 数据增强:对于数据稀缺的领域或任务,可通过回译、同义词替换、句子重组等方式生成新样本,以增加数据多样性,防止过拟合。但需注意,增强过程应保持语义一致性,避免引入误导信息。

- 格式对齐:对于多模态模型(如结合文本与图像),需将不同模态数据对齐到统一表示空间,这涉及复杂的特征提取与映射技术。

三、数据分布与偏差:伦理与社会责任的考量

数据并非中性,它往往反映现实世界中的社会、文化与历史偏差。在大模型预训练中,忽视数据分布问题可能导致模型放大偏见,引发伦理风险。

- 偏差识别:通过统计分析,检测数据在性别、种族、地域、文化等方面的不平衡。例如,若训练数据中男性相关文本远多于女性,模型可能生成带有性别偏见的输出。

- 去偏策略:可采取重采样、生成平衡数据、或在训练目标中加入公平性约束来缓解偏差。构建多样化、包容性的数据源(如涵盖少数群体语言或文化内容)是根本之道。

- 透明化:公开数据来源、处理方法和已知偏差,有助于用户理解模型局限,并促进社区监督。

四、数据安全与隐私:合规性与技术防护

随着数据法规(如GDPR)的完善,预训练中的数据安全与隐私保护变得至关重要。

- 去标识化:移除或模糊文本中的个人身份信息(如姓名、地址),以降低隐私泄露风险。技术手段包括命名实体识别与替换、差分隐私等。

- 版权合规:确保数据使用不侵犯知识产权,可通过使用开源数据集、获取授权或依赖合理使用原则(但需法律评估)来实现。

- 安全过滤:在预处理中嵌入内容安全机制,过滤暴力、仇恨言论等有害信息,以构建更健康的模型输出。

五、数据评估与迭代:持续优化的闭环

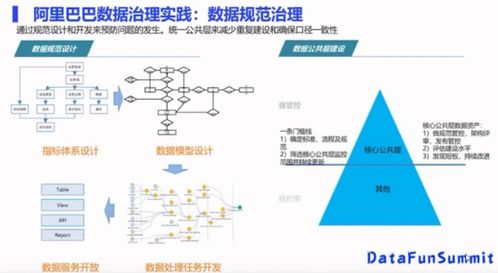

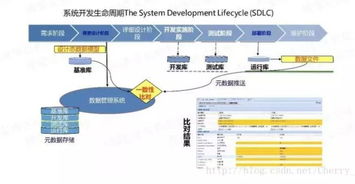

数据处理并非一劳永逸,而是一个需要持续评估与迭代的动态过程。

- 质量评估指标:除了传统的统计指标(如词汇多样性、句子长度分布),可引入模型驱动的评估,例如用初步模型测试数据性能,或通过人工标注验证关键样本。

- 反馈循环:根据模型在实际应用中的表现(如用户反馈、错误分析),反向优化数据采集与处理策略。例如,若模型在特定领域表现不佳,可针对性补充相关语料。

- 可扩展性设计:随着数据量增长,需采用分布式处理框架(如Hadoop、Spark)和自动化流水线,以提升效率并减少人为错误。

数据作为模型之基

数据处理在大模型预训练中扮演着基石角色。它不仅是技术过程,更涉及伦理、法律与社会责任的综合考量。随着模型规模的扩大与应用场景的深化,数据处理将朝着更智能化(如自动清洗与增强)、更公平化(如偏差动态监测)和更安全化(如隐私保护技术融合)的方向发展。唯有在数据层面深思熟虑,才能铸就既强大又负责任的人工智能模型,真正赋能人类社会。